Le videocamere professionali – siano esse PTZ, box camera, document camera o webcam di fascia alta – seguono di pari passo gli sviluppi che stanno alla base della tecnologia di realizzazione dei sensori d’immagine, i dispositivi che convertono la luce incidente raccolta dall’obiettivo in un segnale elettrico che verrà poi elaborato dall’elettronica a valle. I sensori rappresentano la componente chiave da cui dipende la qualità dell’immagine che, a differenza di quanto si possa pensare, non è legata al numero totale di Mpixel (pixel count) “spalmati” su una determinata superficie che identifica la dimensione del sensore, ma alla grandezza del pixel stesso, quella che viene chiamata pixel pitch e che nella maggior parte dei casi equivale anche alla distanza fra il centro di un pixel e quello adiacente, supponendo che non ci sia gap tra uno e l’altro.

Pixel più grandi sono in grado di catturare una maggiore quantità di luce e quindi sono più efficienti, cioè generano una maggior corrente, al contrario di quelli più piccoli. Ecco perché, a parità di numero di numero di pixel totali, un sensore più grande ha prestazioni migliori di uno più piccolo, soprattutto in termini di rumore, come vedremo fra poco.

I sensori più largamente utilizzati nelle videocamere digitali di fascia medio-alta sono del tipo CMOS (acronimo di Complementary Metal-Oxide Semiconductor) che hanno quasi del tutto sostituito quelli di tipo CCD, ad accoppiamento di carica, più diffusi nelle videocamere di sorveglianza a circuito chiuso.

I sensori comunemente utilizzati nelle videocamere hanno i pixel disposti sotto forma di matrice regolare (righe e colonne) con diagonale variabile da 1/2,3” (corrispondenti a 6,17 x 4,55 mm) a 1” (13,2 x 8,8 mm) e risoluzioni comprese fra 2 e 12 Mpixel. I maggiori produttori mondiali di sensori d’immagine per questi dispositivi sono Sony, Omnivision, Samsung, Canon e Toshiba.

Il problema del rumore

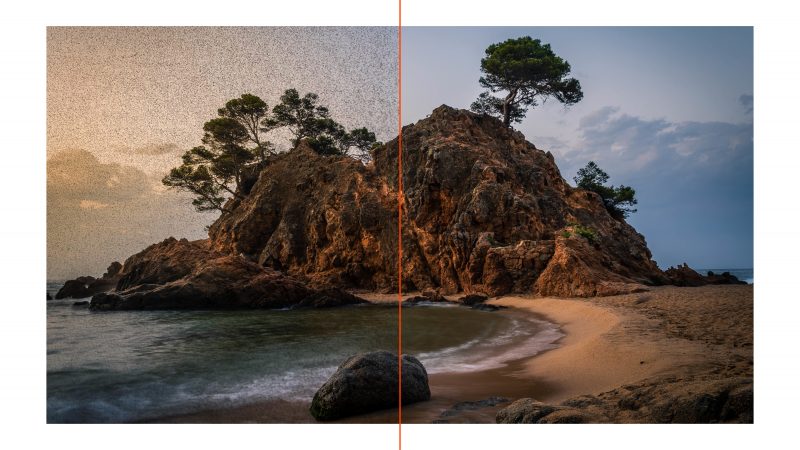

Abbiamo accennato poco fa al problema del rumore, che affligge tutti i sistemi digitali di cattura dell’immagine. Si tratta di un difetto che, nelle riprese video, può diventare molto grave nel caso di scene scarsamente illuminate: è causato dal fatto che, anche quando il sensore si trova al buio, genera comunque una corrente, pur debole, che viene amplificata dai circuiti seguenti e produce, appunto, rumore. Fenomeno ben noto anche in campo fotografico, risulta ancora più fastidioso con i video in quanto la “grana” dovuta al rumore stesso cambia da un fotogramma all’altro, creando un fastidioso effetto che impedisce la visione chiara dei dettagli, diminuisce la risoluzione percepita (i circuiti di soppressione del rumore tendono a “piallare” i dettagli stessi) e modifica la fedeltà dei colori. Una sorta di granulosità che tutti abbiamo sperimentato e che diventa inaccettabile su videocamere di qualità mediocre, rendendone impossibile l’utilizzo in determinate circostanze.

Grazie alla potenza dei processori delle immagini, algoritmi digitali sempre più sofisticati sono in grado di individuare in tempo reale il rumore che si produce nelle riprese video e di limitarlo in modo di conferire all’immagine trasmessa/registrata una miglior qualità. In generale, quindi, si opera da un lato migliorando la tecnologia costruttiva dei sensori e dall’altro gli algoritmi di elaborazione delle immagini. Purtroppo, al momento, non è ancora possibile ricostruire i pixel mancanti, tuttavia sono anche state introdotte sofisticate tecniche di interpolazione che ricostruiscono i pixel inesistenti basandosi su quelli adiacenti, al fine di aumentare la risoluzione percepita e il dettaglio. Parallelamente sono stati sviluppati e dei potenti algoritmi di riconoscimento facciale che riescono a lavorare anche con immagini non molto definite, e ciò è indispensabile in tutti gli utilizzi delle videocamere dove è presente un relatore, per esempio durante una lezione o una conferenza.

Human Detection e intelligenza artificiale (AI)

Il rilevamento umano (Human Detection) e Il riconoscimento facciale nelle videocamere sfruttano una tecnologia in grado d’identificare la sagoma o il volto di una persona attraverso potenti algoritmi e funzioni di calcolo. Il riconoscimento facciale (Face Detection), nello specifico, avviene infatti attraverso software biometrici che mappano le caratteristiche facciali (incluse verie pose ed espressioni) di un individuo in modo matematico e memorizzano i dati come fossero una “stampa” del volto. Questi algoritmi, supportati dalla potenza dei DSP, confrontano in tempo reale l’immagine acquisita e un database interno, che contiene appunto tutti i dati biometrici, al fine di rilevare il volto e assicurare così la perfetta messa a fuoco, esposizione e tracciamento dell’individuo stesso che si muove in uno spazio più o meno ampio.

In questo contesto, il termine usato di “intelligenza” artificiale non è altro che l’estensione del face recognition per poter individuare non solo uno o più volti umani, ma anche le caratteristiche della scena stessa che si sta inquadrando, tipo il contrasto e la luminosità del soggetto rispetto allo sfondo, eventuali dominanti cromatiche, il riconoscimento di particolari elementi o inquadrature, la riduzione del rumore video, l’auto-tracking in modalità presentatore o zona, ecc.

Un esempio? L’inquadratura automatica del campo visivo (FOV) utilizzata su alcuni modelli AVer. L’inquadratura automatica rende lo svolgimento di un meeting più semplice, poiché invece di variare manualmente la stessa per adattare il frame a tutti i partecipanti coinvolti agendo sul movimento angolare dell’obiettivo, è sufficiente premere un pulsante e lasciare che l’intelligenza artificiale imposti il FOV (angolo di campo) corretto.

Tracking di soggetti sempre più avanzato

Da qualche anno, le più sofisticate videocamere PTZ dispongono di sistemi di tracking del soggetto che agiscono in maniera bidimensionale, sia quando lo stesso si muove da sinistra a destra (tracciamento sul palco) che quando si avvicina o si allontana dalla camera.

La modalità di tracciamento sul palco permette di mettere a fuoco e seguire un presentatore che si muove attraverso l’area dello stesso, ad esempio per mostrare contenuti su più display o su uno schermo da proiezione ampio. In questo caso, la messa a fuoco è meno critica in quanto il movimento avviene su un piano perpendicolare rispetto all’obiettivo della camera. Una variante è la modalità a zone, che crea appunto più zone preimpostate per consentire ad un relatore di spostarsi in un’area specifica, entro la quale viene catturato in modo (quasi) fisso anziché in movimento. I contenuti vengono quindi inviati a più display distinti.

Poi esiste la modalità di tracciamento ampia, che offre alla persona inquadrata la flessibilità di lasciare il palco e d’interagire con il pubblico, avvicinandosi o allontanandosi dal punto di ripresa in maniera casuale con la certezza che la camera resti “agganciata” al suo target, anche se altre persone od oggetti entrano nella traiettoria. In questo caso la MAF (Messa A Fuoco) è più critica in quanto il movimento del soggetto, casuale, può avvenire verso il punto di ripresa e successivamente allontanarsi da esso. Un sistema di autofocus veloce e affidabile è quindi indispensabile, anche se sensori relativamente piccoli come quelli usate in queste videocamere perdonano anche qualche errore o “incertezza” vista la profondità di campo piuttosto ampia.

I vari metodi di tracking ora elencati possono anche essere combinati assieme. Fra l’altro, utilizzando un’apposita interfaccia utente web, alcuni modelli di PTZ consentono semplicemente di cliccare su un soggetto target per regolare in modo rapido l’angolo di ripresa e avviare un tracking preciso, garantendo così il re-indirizzamento nel giro di pochi istanti.